微博数据的重要性及数据抓取的概念

微博,作为中国最大的社交媒体平台之一,每天都会产生大量的用户数据。这些数据不仅包括用户发布的内容,还包括评论、点赞、转发等互动信息。这些丰富的社交数据对于营销分析、舆情监控、市场研究以及学术研究等领域都有着极高的利用价值。

微博的数据并不容易直接获取,很多用户的信息、发布的内容,以及互动数据都需要通过特定的方式进行收集和处理。这就是为什么我们需要掌握“数据抓取”技术的原因。所谓的数据抓取,指的是通过程序或工具从网页上自动获取数据的过程。

为什么选择微博作为数据源?

广泛的用户基础:微博拥有上亿的用户群体,产生的数据量庞大,具备极强的代表性。

实时性强:作为社交媒体,微博上的热点事件和舆情可以第一时间反映出来,实时性的数据抓取能帮助企业或个人更快速做出反应。

多维度数据:除了文本内容外,微博还提供评论、点赞、转发等用户行为数据,这些都能提供更加全面的分析视角。

微博数据的抓取不仅帮助企业深入了解用户需求、热点趋势,还能用于研究分析,构建个性化推荐系统等。通过抓取这些数据,企业和个人可以更加精准地做出业务决策。

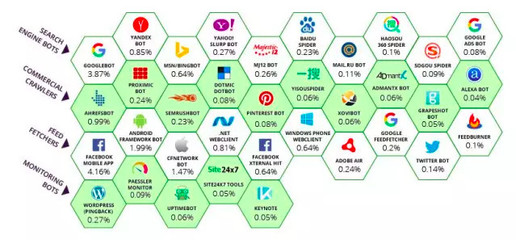

数据抓取的常见方式

对于抓取微博数据,主要有两种方式:通过微博的开放API接口抓取和通过网络爬虫技术抓取。

微博API:

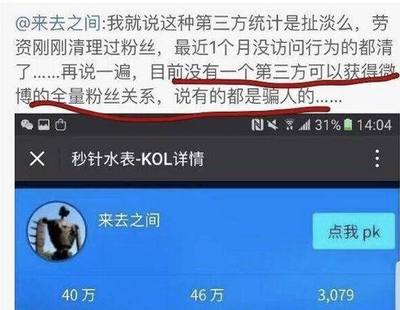

微博提供了官方的API接口,供开发者获取用户公开数据。API接口较为正规和安全,但由于平台的限制,微博API对数据获取量、频率等都有严格的限制,尤其在涉及隐私时数据的权限较为受限。

常用的微博API接口包括:

用户信息接口:获取用户的基本信息,如昵称、粉丝数等。

时间线接口:获取某个用户发布的微博内容。

热门话题接口:获取当前微博热搜榜上的内容和话题。

使用微博API的优势在于数据结构清晰、稳定性好,但由于频率和数据量的限制,API抓取更适合较小规模或长期的监控项目。

网络爬虫:

网络爬虫是一种自动化程序,能够模拟浏览器行为,访问网页并抓取所需的内容。相比微博API,爬虫可以绕过很多API限制,抓取更多公开的数据。但爬虫技术涉及网页结构解析、验证码处理、登录绕过等更为复杂的操作。爬虫抓取存在法律和道德边界,抓取公开数据时应遵循相关平台的用户协议。

常见的爬虫工具包括Python的Scrapy、Selenium等。这些工具通过对网页的HTML解析,将关键信息提取出来。对于微博这种数据结构复杂的社交平台来说,爬虫的灵活性较高。

使用微博API抓取数据的基本步骤

如果你选择使用微博API来抓取数据,以下是基本的步骤:

注册微博开发者账号:

要使用微博API,首先需要在微博开放平台上注册一个开发者账号,并创建应用。通过这个应用,你会获得一个AppKey和AppSecret,这些都是访问API的凭证。

申请授权和Token:

微博API的大部分接口都需要用户授权才能访问。你需要让用户登录微博并授权你的应用,获取到授权Token。这个Token就是你访问用户数据的钥匙。Token有时间限制,因此需要定期刷新或重新获取。

调用微博API:

在获得授权后,你就可以使用API进行数据的请求了。以Python为例,通常使用requests库来发送HTTP请求,通过API地址获取返回的JSON数据。比如,你可以调用用户时间线接口,获取该用户的最新微博内容。

importrequests

url="https://api.weibo.com/2/statuses/user_timeline.json"

params={

'access_token':'YOUR_ACCESS_TOKEN',

'screen_name':'target_user',

'count':10#这里的10表示抓取最新10条微博

}

response=requests.get(url,params=params)

data=response.json()

print(data)

解析和存储数据:

微博API返回的数据通常是JSON格式。你可以根据需求提取出关键信息(如微博文本、发布时间、点赞数等),并将这些数据存储到本地或数据库中进行后续分析。

优点:微博API抓取数据简单、结构化,且数据来源合法。

缺点:API限制较多,无法高频抓取大量数据。

使用网络爬虫抓取微博数据

如果你需要更大量或定制化的数据,网络爬虫则是一个不错的选择。以下是基本的操作流程:

安装爬虫工具:

Python中的Scrapy是一个强大的爬虫框架,适合大规模数据抓取。而Selenium则可以模拟浏览器行为,适合处理需要登录的网站或动态加载内容的页面。

通过以下命令可以安装Scrapy:

pipinstallscrapy

构建爬虫逻辑:

使用爬虫的核心是编写抓取逻辑,解析网页结构。以微博的页面为例,你需要分析HTML源码,找到微博内容所在的标签,通过XPath或CSSSelector提取数据。

importscrapy

classWeiboSpider(scrapy.Spider):

name="weibo_spider"

start_urls=['https://weibo.com/']

defparse(self,response):

forpostinresponse.css('div.post-content'):

yield{

'text':post.css('p::text').get(),

'likes':post.css('span.likes::text').get(),

}

数据存储与分析:

数据抓取完成后,可以将数据保存为CSV文件或存储到数据库中,进行进一步的分析处理。通过机器学习算法或自然语言处理技术,你可以对微博数据进行情感分析、话题分类等操作。

优点:爬虫可以突破API的限制,抓取更灵活。

缺点:技术门槛较高,且需遵循平台规定,避免违法抓取。

无论是使用微博API还是网络爬虫,每种方式都有其优势与局限。根据你的需求规模、数据获取频率以及技术熟悉程度,选择最合适的方法,才能高效地获取微博数据,并最大化其价值。